GeoWerkstatt-Projekt des Monats Oktober 2023

Projekt: SILKNOW

Forschende: apl. Prof. Dr. techn. Franz Rottensteiner, Mareike Dorozynski

Projektidee: Seidenes Erbe in der Wissensgesellschaft: von Lochkarten zu Big Data, Deep Learning und visuellen/greifbaren Simulationen.

Seidenstoffe sind Teil des kulturellen Erbe Europas. Um das Wissen über Seidenstoffe, Webtechniken und weitere Informationen rund um die europäische Seidenkultur zu erhalten, weiterzugeben und für die Forschung bereitzustellen, hat sich das Projekt SILKNOW (http://silknow.eu/) zur Aufgabe gemacht, mit Hilfe modernster IT-Technik die umfangreichen Sammlungen noch besser aufzubereiten und zugänglich zu machen.

Als Basis dafür ist ein Wissensgraph entstanden, in dem jedes Seidenobjekt einem Rekord entspricht. Darin sind Metadaten wie etwa die Zeit und der Ort der Produktion enthalten und häufig auch Bilder der Seidenobjekte.

Unsere Aufgabe in diesem Projekt lag darin, Methoden der Künstlichen Intelligenz Verfahren zu entwickeln, mit denen sich die Metadaten automatisch aus den Bildern ableiten lassen (Bildklassifizierung) und mit denen man über Bilder im Wissensgraph nach Objekten suchen kann (Bildabfrage).

Für die Bildklassifizierung haben wir ein Convolutional Neural Network (CNN) entwickelt. Dieses CNN kann die Metadaten „Produktionsort“, „Produktionszeit“, „Produktionstechnik“, „Material“ und „Darstellung“ gleichzeitig aus Bildern von Seidenobjekten prädizieren. Das ist hilfreich, wenn bei Objekten nicht alle Metadaten im Datensatz eingetragen sind. Dann kann das CNN die fehlenden Metadaten aus den Bildern prädizieren und den Wissensgraphen dadurch automatisch vervollständigen. Die erreichte Genauigkeit lag je nach Variable zwischen 53% und 86%.

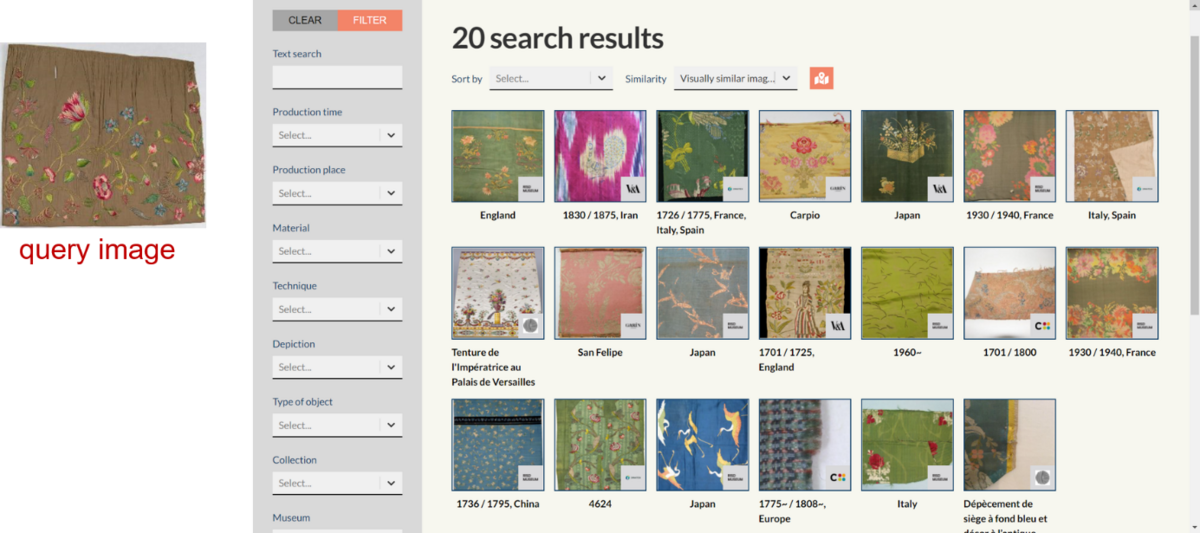

Für die Bildabfrage haben wir ein CNN entwickelt, welches aus einem Bild einen Merkmalsvektor (Deskriptor) ableitet. Zunächst mussten wir uns ein Modell überlegen, mit dem sich die Ähnlichkeit der Seidenobjekte beschreiben lässt. Wir haben dafür vor allem die Metadaten herangezogen, aber auch die Farbverteilung der Bilder berücksichtigt. Daraus haben wir eine Trainingsmethode für das CNN entwickelt. Nach dem Training ließ sich für jedes Bild im Wissensgraph ein Deskriptor berechnen. Bei der Bildabfrage sucht das CNN nun die dem Deskriptor des Suchbilds ähnlichsten Deskriptoren und präsentiert die damit verknüpften Objekte als Ergebnis. In Experimenten stimmten die Metadaten der so gefundenen Bilder mit jenen des Suchbilds je nach Variable zwischen 44% und 89% überein.

Diese Bildklassifizierung und Bildabfrage sind in die Plattform „ADAsilk“ eingebettet. Über die Plattform lassen sich alle im SILKNOW Wissensgraphen enthaltene Seidenobjekte suchen: https://ada.silknow.org/

©

IPI

©

IPI